浅谈MyBatis缓存

本文共 2717 字,大约阅读时间需要 9 分钟。

学过MyBatis框架的都知道,MyBatis自带一二级缓存,并且还有第三方给MyBastis提供二级缓存,例如ehcache、memcache,本文粗略的讲一下这个几个缓存的机制和使用吧。

首先解释一下缓存存在的意义:他避免了相同的sql查询语句频繁的去访问数据库。自动的把第一次查询的结果放在了缓存中,后续再次查询该同样的对象时,则直接从缓存中查询该对象即可。 一级缓存: MyBatis默认开启一级缓存,范围是同一个SqlSession对象。public static void query() throws IOException { Reader reader = Resources.getResourceAsReader("conf.xml"); SqlSessionFactory sessionFactory = new SqlSessionFactoryBuilder().build(reader); SqlSession session = sessionFactory.openSession(); StudentMapper studentMapper = session.getMapper(StudentMapper.class); Student3 student1 = studentMapper.queryStudentByStuno(1); Student3 student2 = studentMapper.queryStudentByStuno(1); System.out.println(student1.getStuNo()+","+student1.getStuName()); System.out.println(student2.getStuNo()+","+student2.getStuName()); session.close();} 比如上面的代码,student1和student2来自同一个SqlSession产生的StudentMapper,所以共享了缓存。开启日志发现明显只执行了一条sql语句:

这里补充说明一下:执行commit()语句会清除一级缓存,比如在上面的代码中加上这一样一行:

这里补充说明一下:执行commit()语句会清除一级缓存,比如在上面的代码中加上这一样一行: Student3 student1 = studentMapper.queryStudentByStuno(1);session.commit();Student3 student2 = studentMapper.queryStudentByStuno(1);

执行就会发现MyBatis执行了两条sql语句,缓存被清理了:

二级缓存: 开启二级缓存需要手动开启,范围是同一个namespace: 需要三步配置: 1.在MyBatis核心配置文件中加入配置信息:

二级缓存: 开启二级缓存需要手动开启,范围是同一个namespace: 需要三步配置: 1.在MyBatis核心配置文件中加入配置信息: 2.在具体的Mapper.xml中加入,表明该接口开启了二级缓存!

如果想某个标签体不使用二级缓存,可以在相应的< select >中加上属性useCache=“false”!

3.准备缓存的对象,必须实现了序列化接口,将用到的实体类implements Serializable!(级联属性也需要序列化)下面开始说使用的问题:

二级缓存不是自动将第一个sql语句放入缓存,需要session.close()语句将sql语句刷进缓存。public static void query() throws IOException { Reader reader = Resources.getResourceAsReader("conf.xml"); //可以通过build的第二个参数环境 指定数据库环境 SqlSessionFactory sessionFactory = new SqlSessionFactoryBuilder().build(reader); SqlSession session = sessionFactory.openSession(); StudentMapper studentMapper = session.getMapper(StudentMapper.class); Student3 student3 = studentMapper.queryStudentByStuno(2); session.close(); //第二次查询 SqlSession session2 = sessionFactory.openSession(); StudentMapper studentMapper2 = session2.getMapper(StudentMapper.class); Student3 student4 = studentMapper2.queryStudentByStuno(2); session2.close(); System.out.println(student3.getStuNo()+","+student3.getStuName()); System.out.println(student4.getStuNo()+","+student4.getStuName());} 可以看出上面的查询语句来源的并不是同一个SqlSession对象,但却都从StudentMapper.class的反射(也就是同一个namespace)获取动态代理对象studentMapper!

如果删掉session.close()语句,则运行结果是这样的:

如果删掉session.close()语句,则运行结果是这样的:  同样可以用commit()语句清除缓存,但需要注意的是不能是查询自身的commit,需要用增删改语句的commit来清除。还可以在mapper.xml文件中的< select >标签中增加属性 flushCache="true"来自动清除缓存!

同样可以用commit()语句清除缓存,但需要注意的是不能是查询自身的commit,需要用增删改语句的commit来清除。还可以在mapper.xml文件中的< select >标签中增加属性 flushCache="true"来自动清除缓存! 再说一下第三方提供的二级缓存(ehcache):

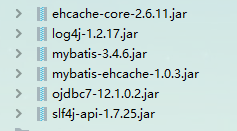

1.导入三个jar:ehcache-core.jar,mybatis-ehcache.jar和self-api.jar

2.编写Ehcache.xml并放在内路径中:

2.编写Ehcache.xml并放在内路径中: 3.其余的配置和Mybatis自带的二级缓存差不多!唯一需要注意的是具体的mapper.xml中不再是配置< cache />,而是:

转载地址:http://ryhe.baihongyu.com/

你可能感兴趣的文章

NIFI从MySql中增量同步数据_通过Mysql的binlog功能_实时同步mysql数据_根据binlog实现update数据实时同步_实际操作05---大数据之Nifi工作笔记0044

查看>>

NIFI从MySql中增量同步数据_通过Mysql的binlog功能_实时同步mysql数据_根据binlog实现数据实时delete同步_实际操作04---大数据之Nifi工作笔记0043

查看>>

NIFI从MySql中增量同步数据_通过Mysql的binlog功能_实时同步mysql数据_配置binlog_使用处理器抓取binlog数据_实际操作01---大数据之Nifi工作笔记0040

查看>>

NIFI从MySql中增量同步数据_通过Mysql的binlog功能_实时同步mysql数据_配置数据路由_实现数据插入数据到目标数据库_实际操作03---大数据之Nifi工作笔记0042

查看>>

NIFI从MySql中增量同步数据_通过Mysql的binlog功能_实时同步mysql数据_配置数据路由_生成插入Sql语句_实际操作02---大数据之Nifi工作笔记0041

查看>>

NIFI从MySql中离线读取数据再导入到MySql中_03_来吧用NIFI实现_数据分页获取功能---大数据之Nifi工作笔记0038

查看>>

NIFI从MySql中离线读取数据再导入到MySql中_不带分页处理_01_QueryDatabaseTable获取数据_原0036---大数据之Nifi工作笔记0064

查看>>

NIFI从MySql中离线读取数据再导入到MySql中_无分页功能_02_转换数据_分割数据_提取JSON数据_替换拼接SQL_添加分页---大数据之Nifi工作笔记0037

查看>>

NIFI从Oracle11G同步数据到Mysql_亲测可用_解决数据重复_数据跟源表不一致的问题---大数据之Nifi工作笔记0065

查看>>

NIFI从PostGresql中离线读取数据再导入到MySql中_带有数据分页获取功能_不带分页不能用_NIFI资料太少了---大数据之Nifi工作笔记0039

查看>>

nifi使用过程-常见问题-以及入门总结---大数据之Nifi工作笔记0012

查看>>

NIFI分页获取Mysql数据_导入到Hbase中_并可通过phoenix客户端查询_含金量很高的一篇_搞了好久_实际操作05---大数据之Nifi工作笔记0045

查看>>

NIFI分页获取Postgresql数据到Hbase中_实际操作---大数据之Nifi工作笔记0049

查看>>

NIFI同步MySql数据_到SqlServer_错误_驱动程序无法通过使用安全套接字层(SSL)加密与SQL Server_Navicat连接SqlServer---大数据之Nifi工作笔记0047

查看>>

NIFI同步MySql数据源数据_到原始库hbase_同时对数据进行实时分析处理_同步到清洗库_实际操作06---大数据之Nifi工作笔记0046

查看>>

Nifi同步过程中报错create_time字段找不到_实际目标表和源表中没有这个字段---大数据之Nifi工作笔记0066

查看>>

【Flink】Flink 1.9 版本 web UI 突然没有日志

查看>>

NIFI大数据进阶_FlowFile拓扑_对FlowFile内容和属性的修改删除添加_介绍和描述_以及实际操作---大数据之Nifi工作笔记0023

查看>>

NIFI大数据进阶_FlowFile生成器_GenerateFlowFile处理器_ReplaceText处理器_处理器介绍_处理过程说明---大数据之Nifi工作笔记0019

查看>>

NIFI大数据进阶_FlowFile生成器_GenerateFlowFile处理器_ReplaceText处理器_实际操作---大数据之Nifi工作笔记0020

查看>>